|

Note article |

|||||

La relevancia de orientar la rendición de cuentas hacia el impacto en la investigación aplicada: una propuesta para la Universidad Autónoma de Querétaro

Eduardo Luna Sánchez Candidato al Doctorado en Geografía por la Universidad Nacional Autónoma de México. Profesor Investigador en la Universidad Autónoma de Querétaro.

Mayra Juliana Chávez Alcalá Maestra en Gestión Integrada de Cuencas. Profesora Investigadora en la Universidad Autónoma de Querétaro.

Resumen Se presenta un análisis del sistema de evaluación de la actividad científica que utiliza la Universidad Autónoma de Querétaro (UAQ). La finalidad es identificar si la política científica del gobierno mexicano ejerce una influencia sobre su sistema de evaluación y, a la vez, reconocer si su propósito es compatible con el enfoque de la Responsabilidad Social Universitaria, modelo de gestión adoptado por la administración actual (2018-2021). Para acceder a la información se combinó el análisis de documentos institucionales con un enfoque etnográfico orientado al aprendizaje. Se identificó que el sistema de evaluación de la UAQ, al concentrarse en la medición de la productividad académica, se alinea con la política científica federal. Esto es crucial en el contexto de limitación presupuestal que atraviesa la institución. Sin embargo, no se garantiza la congruencia con el enfoque de la Responsabilidad Social Universitaria, pues no es posible equiparar la producción de conocimiento con su impacto. A manera de conclusión se hace una propuesta de reforma procedimental, con la finalidad de incorporar elementos que fortalezcan la capacidad de la universidad para rendir cuentas sobre el impacto de sus investigaciones aplicadas.

The relevance of guiding accountability towards impact on applied research: a proposal for the Autonomous University of Querétaro

Abstract The paper presents an analysis of the scientific evaluation system used by the Autonomous University of Querétaro (UAQ). The purpose is to identify if the federal scientific policy has an influence on its evaluation system and, at the same time, to recognize if its purpose is compatible with the University Social Responsibility approach, a management model adopted by UAQ´s current administration (2018-2021). An analysis of institutional documents was combined with an ethnographic approach to gain access to the information. UAQ´s evaluation system, aligned with the federal scientific policy, seeks to measure academic productivity. Because of the budget shortfall that UAQ is going through, this alignment is crucial. However, congruence with the University Social Responsibility approachis not guaranteed, since it is not possible to equate the production of knowledge with its impact. A procedural reform proposal is made, with the purpose of incorporating elements that strengthen UAQ´s capacity to report the impact of applied research.

I. INTRODUCCIÓN Las universidades reciben recursos públicos para la investigación pues se espera que el conocimientogenereefectos positivos para la sociedad (Ramos et al., 2018). Por ello, para rendir cuentas, el gobierno y lasuniversidades públicasson responsables de evaluar el impacto social de las actividades científicas.

Sería un error pensar que las investigaciones son, en sí mismas, una prueba de efectos sociales positivos (Vallaeys, 2014). Esto se ha demostrado desde la década de los setenta por investigaciones que han tematizado el uso del conocimiento científico (Weiss 1977, 1979).Aun así, en la política científica mexicana, ha mantenido su hegemonía un enfoque evaluativo que utiliza la producción de conocimiento científico como indicador proxy de su efectividad (Gil y Contreras, 2017).

En México, las Universidades Públicas Estatales poseen autonomía institucional para definir sus procedimientos organizacionales. Sin embargo, se ha señalado que las políticas federales ejercen una influencia importante sobre sus sistemas de evaluación (Galaz et al., 2008). En ese sentido, es importante estudiar los efectos positivos y negativos de enfoques evaluativos que, erróneamente, podrían considerarse como los únicos válidos para evaluar la actividad científica (Vasen y Lujano, 2017).

En México, las Universidades Públicas Estatales poseen autonomía institucional para definir sus procedimientos organizacionales. Sin embargo, se ha señalado que las políticas federales ejercen una influencia importante sobre sus sistemas de evaluación (Galaz et al., 2008). En ese sentido, es importante estudiar los efectos positivos y negativos de enfoques evaluativos que, erróneamente, podrían considerarse como los únicos válidos para evaluar la actividad científica (Vasen y Lujano, 2017).

Mientras tanto, en algunos países de la Unión Europea, la comprensión de la brecha entre la producción de conocimiento y su impacto ha provocado un replanteamiento de la forma en la que se evalúa la práctica científica (Van der Meulenet al., 2010; Spaapenet al., 2011; Rafolset al., 2017). Estas propuestas han buscado mejores maneras de conectar a los científicos con la sociedad y han sido sintetizadas en conceptos como transdisciplina, interacciones productivas, o intermediación de conocimientos (knowledgebrokering) (Spaapen y Van Drooge, 2011; Vallaeys, 2014; Turnhout, 2018).

Desde esta perspectiva, se han hecho invitaciones para valorar la ciencia, no por su capacidad para representar la realidad a través de modelos, sino por su orientación hacia la resolución de problemas concretos junto con otros actores que participen tanto en la definición del problema como en la creación de soluciones (Turnhout, 2018).

Desde esta perspectiva, se han hecho invitaciones para valorar la ciencia, no por su capacidad para representar la realidad a través de modelos, sino por su orientación hacia la resolución de problemas concretos junto con otros actores que participen tanto en la definición del problema como en la creación de soluciones (Turnhout, 2018).

Es importante recalcar que la investigación nopretendeevaluarla efectividad de las investigaciones llevadas a cabo en la UAQ. En cambio, se exploran los factores que influyen sobre su sistema de evaluación, para concluir si es útil o no para medir el impactodela práctica científica.

Es importante aclarar que el análisis se concentra en la evaluación de investigaciones aplicadas. Si bien, toda investigación busca generar un cambio al aportar nuevos conocimientos, se considera que una investigación es aplicada cuando tiene una intencionalidad expresa de utilizar los conocimientos generados para atender problemas sociales. En este sentido, las investigaciones aplicadas son un reflejo del compromiso que las universidades públicas tienen con su entorno.

Es importante aclarar que el análisis se concentra en la evaluación de investigaciones aplicadas. Si bien, toda investigación busca generar un cambio al aportar nuevos conocimientos, se considera que una investigación es aplicada cuando tiene una intencionalidad expresa de utilizar los conocimientos generados para atender problemas sociales. En este sentido, las investigaciones aplicadas son un reflejo del compromiso que las universidades públicas tienen con su entorno.

Al resaltar la importancia de medir el impacto de las investigaciones, no se pretende cuestionar, en modo alguno, la relevancia de lasinvestigaciones básicas.Sin duda, comprender mejor un fenómeno o reflexionar sobre diferentes aspectos de la condición humana, más allá de una utilidad latente, tiene un valor intrínseco.

Tampoco se pretende generar la impresión de que todas las investigaciones aplicadas deben tener impactos positivos, aunque todas precisan orientarse hacia ese objetivo. La actividad científica es incierta por definición, se asumen riesgos y se prueban nuevas ideas todo el tiempo, por lo que fallar es un derecho que se da por descontado. En este contexto, la evaluación es una herramienta de aprendizaje que aporta conocimientos para mejorar el diseño de las investigaciones.

Tampoco se pretende generar la impresión de que todas las investigaciones aplicadas deben tener impactos positivos, aunque todas precisan orientarse hacia ese objetivo. La actividad científica es incierta por definición, se asumen riesgos y se prueban nuevas ideas todo el tiempo, por lo que fallar es un derecho que se da por descontado. En este contexto, la evaluación es una herramienta de aprendizaje que aporta conocimientos para mejorar el diseño de las investigaciones.

.

2. METODOLOGÍA

En el marco de un estudio de caso, se combinó el análisis de documentos institucionales con un enfoque etnográfico orientado al aprendizaje (Eyben, 2009) para identificar si la política científica federal ejerce una influencia sobre el sistema de evaluación de la UAQ y, a la vez, para reconocer si su propósito es compatible con el enfoque de la Responsabilidad Social Universitaria.

En el marco de un estudio de caso, se combinó el análisis de documentos institucionales con un enfoque etnográfico orientado al aprendizaje (Eyben, 2009) para identificar si la política científica federal ejerce una influencia sobre el sistema de evaluación de la UAQ y, a la vez, para reconocer si su propósito es compatible con el enfoque de la Responsabilidad Social Universitaria.

Los estudios de caso son un tipo de investigación cualitativa que estudia un fenómeno en su propio contexto. El método permite vincular datos empíricos con proposiciones teóricas, por ello, es útil para verificar si las teorías funcionan en el mundo real (Yin, 2009).

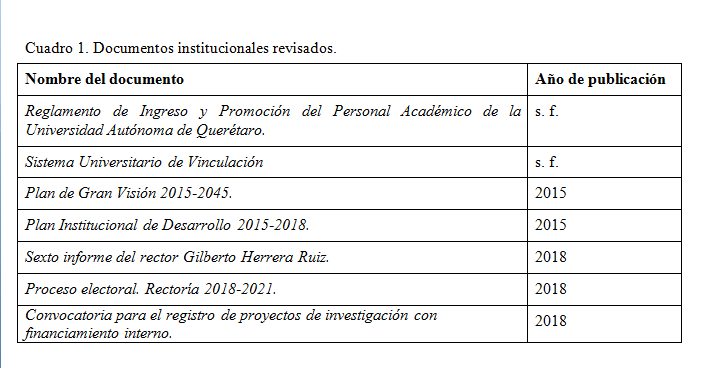

La recopilación de documentos relacionados con las evaluaciones académicas se llevó a cabo a través de una exploración de la página web institucional de la UAQ. De esa manera se tuvo acceso a convocatorias, documentos de planeación estratégica y formatos de registro de proyectos de investigación (Cuadro 1). Además, se recopiló información sobre la política científica del gobierno federal a través de una revisión de investigaciones que han abordado el tema.

El enfoque se apoya en la reflexividad como medio para tematizar una situación que se considera problemática. El proceso se lleva a cabo a través de preguntas de doble ciclo, con las que se analizan supuestos que están detrás de las acciones, las implicaciones de éstas, y las relaciones de poder involucradas. Su finalidad es examinar el comportamiento propio para explorar formas de modificar estructuras institucionales incongruentes , dado que bloquean objetivos que se valoran, como la posibilidad de orientar la evaluación de investigaciones hacia la medición de impactos.

La perspectiva se encuentra en el campo de interacción entre agencia y estructura. Piensa que, aunque moldeados por el contexto social, los integrantes de organizaciones tienen la autonomía suficiente para decidir si contribuyen en la reproducción de estructuras existentes o si intentan cambiar la situación para mejor (Eybenet al., 2007).

Desde este punto de vista, los investigadores, que también forman parte de la organización estudiada, retoman su experiencia personal para analizar el sistema de evaluación académica de la UAQ. Esta perspectiva situada es un lugar privilegiado para explorar los procedimientos organizacionales vinculados con la evaluación y, a la vez, para proponer reformas que permitan responder a modelos deseados de desempeño organizacional.

El abordaje metodológico permite cuestionar supuestos existentes sobre la implementación del modelo de gestión universitaria, y generar hipótesis de trabajo sobre la influencia que tiene el sistema de evaluación sobre el comportamiento de los investigadores en la UAQ.

3. MARCO ANALÍTICO

3.1Evaluación académica basada en resultados

Hay circunstancias que están fuera del control de una organización, las cuales influyen sobre el tipo de decisiones que se pueden tomar al interior de ésta. El rol de este entorno es crucial para el uso de las evaluaciones, pues puede incidir tanto en la producción de evaluaciones como sobre la cultura de una organización.

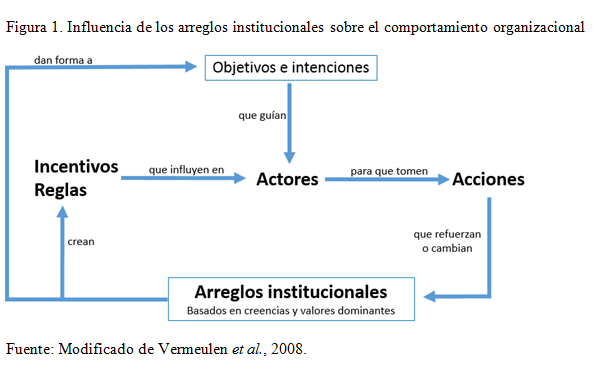

La injerencia que tiene el contexto sobre la actuación de una organización ha sido estudiada por diversos investigadores del campo del desarrollo (Lewis et al. 2003; Guijt, 2008). Se sabe que las organizaciones operan bajo arreglos institucionales que norman su actuación. Estos arreglos, basados en creencias y valores dominantes, establecen mecanismos (p. ej. reglas, procedimientos, o incentivos) que tienen influencia sobre su comportamiento (Figura 1). Los arreglos pueden reflejar relaciones de poder entre organizaciones, sobre todo cuando existe un desbalance en la determinación de las creencias y valores hegemónicos (Lewis et al. 2003).

Actualmente, el enfoque de Gestión basada en Resultados (GbR) tiene una influencia directa sobre el propósito de los sistemas de evaluación en organizaciones que manejan recursos públicos.

Uno de los objetivos de la GbR es mejorar el funcionamiento de las organizaciones a través de procedimientos gerenciales que les permitan ser más eficaces (González, 2013). Desde esta perspectiva, las organizaciones rinden cuentas con resultados, los cuales se entienden como el valor público generado por las organizaciones al cubrir las necesidades e intereses de los ciudadanos (González y Cerdán, 2008).

En este contexto, las evaluaciones son fundamentales para determinar la obtención de resultados. Sin embargo, se ha señalado la tendencia de simplificarlas para sólo valorar el desempeño (Ebrahim, 2003).

Como consecuencia, las evaluaciones se utilizan para establecerun estándar de actuación adecuado, normalmente valorado a través de indicadores de medición sencilla (Edwards y Hulme, 1996, Cousinset al., 2015). Por este motivo, en este tipo de evaluaciones, el significado del concepto “resultados”, originalmente ligado al impacto, se degrada al vincularse a la obtención de productos tangibles que se asume son predictores del valor público generado.

En el ámbito académico, el sistema de evaluación orientado a resultados se caracteriza por emplear indicadores para medir cuantitativamente la productividad de los investigadores. Para ello, dependiendo de la disciplina, se utilizan métricas como la cantidad de publicaciones, el número de investigaciones altamente citadas, el número de tesis dirigidas, el número de ponencias y, el número de artículos publicados en revistas de prestigio (Vasen y Lujano, 2017).

Este enfoque, predominante en la política científica latinoamericana, asume que las publicaciones sujetas a un proceso de arbitraje pueden medir la calidad de las investigaciones, y que por tanto son útiles para valorar el desempeño de un investigador. Además de la evaluación por pares, el enfoque recurre a índices globales de citas para cuantificar el impacto de las publicaciones (Vasen y Lujano, 2017). En este sentido, el impacto se entiende como la influencia que el nuevo conocimiento ha tenido sobre otras investigaciones.

Éstas son algunas de las limitaciones de la evaluación académica basada en resultados:

1. En investigaciones aplicadas no es posible equiparar la producción de conocimiento con su impacto. Para lograr los cambios en las condiciones sociales, económicas o ambientales sobre las que se pretende incidir, es necesario que el conocimiento generado tenga un efecto sobre el comportamiento de otros actores (Netherlands Organization for Scientific Research, s.f.). En general, es un error asumir que los grupos involucrados accederán, leerán, entenderán y utilizarán los artículos científicos para tomar decisiones (Salafskyet al., 2001).

Por ello, al homogeneizar las métricas de evaluación utilizadas para valorar distintas disciplinas científicas, se omite la valoración de las actividades de intercambio que son necesarias para promover el uso del conocimiento en las investigaciones aplicadas (Chavarro y Ràfols, 2018).

Si bien, conseguir los impactos deseados se encuentra más allá de la esfera de influencia de una investigación, el investigador sí puede interactuar con otros actores para incidir en su toma de decisiones. En este sentido, el efecto medible de una investigaciónse entiende como “una ocasión demostrable de influencia de la investigación académica en otro actor u organización” (LSE Public Policy Group, 2011, pág. 5).

2. La valoración del desempeño de los investigadores se fundamenta en números y no en juicios de valor basados en el efecto que han tenido sus proyectos. Si bien, los datos cuantitativos son útiles para tomar decisiones (p. ej. de contratación, promoción laboral, o financiamiento), estos no deben sustituir la valoración experta sobre el mérito de las investigaciones(Hickset al., 2015). De lo contrario, la evaluación corre el riesgo de adherirse al principio “más es mejor” (Bensinget al., 2013).

Por este motivo, si se evalúa el desempeño en función del número de publicaciones, podría generarse una visión de corto plazo que incentiva la producción de conocimientos, pero que no facilita el involucramiento de los investigadores en procesos deliberativos para promover cambios transformacionales(Vasen y Lujano, 2017).

3. Basar la evaluación en métricas cuantitativas puede provocar el desplazamiento de objetivos. De esta manera, como meta a conseguir, la búsqueda del impacto de las investigaciones puede ser sustituida por el aumento en el número de publicaciones (Hickset al., 2015). Este fenómeno psicológico, conocido como surrogar, expresa la tendencia con la que se pierden de vista los constructos estratégicos que las mediciones intentan representar, para actuar como si las medidas fueran los constructos de interés (Bentley, 2018).

A través de la Ley de Campbell o la Ley de Goodhart , se ha expresado la tendencia con la que los sistemas de rendición de cuentas que miden e incentivan el desempeño, al hacerlo, promueven su distorsión. Esto es así, pues causan que aquellos que son valorados modifiquen su comportamiento para ajustarlo a las métricas utilizadas, con lo que alteran los resultados.

De esta manera, al ser medidos de forma frecuente, los evaluados se hacen mejores en el cumplimiento de los requisitos, pero no necesariamente esto los hace desempeñarse mejor en el mundo real (Bovenset al., 2008,pág. 228).

Como respuesta a estas limitaciones, en algunos países de la Unión Europea se están explorando mecanismos de evaluación que estimulen la rendición de cuentas de la academia. Con ello se busca mejorar la manera en la que se mide el impacto social de la actividad científica, y a la vez, promover la colaboración entre científicos y otros actores (Arocenaet al., 2018; Robinson et al., 2018).

En ese sentido, se han propuesto diferentes metodologías para evaluar la relevancia social de las investigaciones (Van der Meulenet al., 2010; Spaapenet al., 2011; Bensinget al., 2013). En general, más que auditar el desempeño de los investigadores, estos enfoques estudian interacciones paraentender qué mecanismos generan un impacto.

3.2. La influencia de la política científica del gobierno mexicano sobre los sistemas universitarios de evaluación.

En México, las Universidades Públicas Estatales (UPE) poseen autonomía institucional, por lo que son capaces de definir sus propias directrices de evaluación. Sin embargo, se ha señalado que las políticas científicas de la federación ejercen una influencia importante sobre sus sistemas de evaluación (Galaz et al. 2008).

La influencia existe, pues las UPE atraviesan un contexto de carestía presupuestal que ha hecho indispensable la gestión de recursos adicionales a los subsidios que reciben (Mendoza, 2011). Por ello, participan en programas federales que les otorgan financiamiento para su mejora a cambio de cumplir con ciertos indicadores de desempeño (Galaz et al., 2008).

Por ejemplo, con la finalidad de mejorar la gestión de las Instituciones de Educación Superior (IES), el Programa Integral de Fortalecimiento Institucional (PIFI) y el Programa Fortalecimiento de la Calidad Educativa (PFCE) han promovido en las universidades la realización de evaluaciones participativas para crear planes institucionales de desarrollo (Vidaurri y Luna, 2017).

Para evaluar el desempeño de las IES, estos programas utilizan indicadores que miden los avances institucionales en relación a su “capacidad y competitividad académica”. El criterio de la capacidad académica es la que se relaciona con el desempeño de los académicos que trabajan en la organización, y se estima en función de la proporción de académicos de tiempo completo que a) cuentan con posgrado, b) tienen el perfil deseable del Programa de Desarrollo del Profesorado (PRODEP), c) tienen un nivel de productividad que les permite formar parte del Sistema Nacional de Investigadores (SNI)y d) forman parte de Cuerpos Académicos (Vidaurri y Luna, 2017).

Dada la importancia de los fondos concursables, las UPE han retomado esos indicadores como parte de sus procedimientos de contratación y promoción laboral (Gil, 2014; Gil y Contreras, 2017). Esto, a su vez, influye en el comportamiento de los académicos, pues determina qué actividades y resultados son valorados por la institución.

De manera paralela a los programas de mejora de la gestión de las UPE, el gobierno federal ha implementado desde la década de los noventa una serie de políticas que han tenido como población objetivo a los académicos mexicanos. En general, su objetivo ha sido realizar transferencias monetariascondicionadas en función del cumplimiento de expectativas de desempeño.

Estas políticas, basadas en la lógica del pago por mérito, tienen un peso importante en la estructura del ingreso de los profesores de tiempo completo. Actualmente, existen tres fuentes principales de remuneración : 1) el salario de la institución, 2) un programa interno de estímulos al desempeño que es diseñado por cada universidad, y 3) programas federales de pago por mérito, como el SNI o el PRODEP (Galaz et al., 2008).

El Sistema Nacional de Investigadores promueve características deseadas entre los investigadores, pues asume que son una condición necesaria para garantizar la calidad del trabajo científico. Entre ellas se encuentran tener el grado de doctor, formar recursos humanos de alto nivel, y tener una alta productividad académica (Gil, 2014).

La productividad académica, medida a través de publicaciones en revistas reconocidas, capítulos de libros, y libros editados o coordinados, es especialmente importante para la permanencia y promoción del académico en las distintas categorías que maneja el SNI (Galaz et al., 2008).

En el área donde son evaluadas distintas disciplinas de las ciencias sociales, como los geógrafos, sociólogos y economistas, la cantidad de publicaciones es el principal indicador que se valora. Gil y Contreras (2017) afirman que es así, pues no se cuenta con indicadores de impacto estandarizados o reconocidos para orientar juicios de valor.

Por su parte, el Programa para el Mejoramiento del Profesorado (PROMEP) y el Programa para el Desarrollo Profesional Docente (PRODEP), han tenido el objetivo de profesionalizar a los Profesores de Tiempo Completo (PTC), de manera que alcancen un “perfil deseable” al alcanzar, entre otros criterios, el nivel de productividad académica requerido. Para ello, se promueve que los PTC se integren dentro de cuerpos académicos que reciben apoyos financieros para implementar proyectos capaces de “transformar su entorno” (SEP, 2018, pág. 16). De la misma manera que en el SNI, el indicador utilizado para medir el desempeño de los PTC es el número de publicaciones.

Como ya se ha señalado, este enfoque de evaluación basado en resultados es insuficiente para juzgar de manera adecuada el impacto de las investigaciones aplicadas. Además, corre el riesgo de promover un comportamiento administrativo estratégico en los académicos, que los lleve a destinar más tiempo para cumplir con requisitos de desempeño generadores de ingresos económicos, que en actividades necesarias para que sus investigaciones tengan un impacto (Galaz y Gil, 2013; Suárez y Muñoz, 2004).

El comportamiento de los académicos, sobrecargados además por actividades administrativas y de docencia (Galaz et al., 2012), responde a las reglas e incentivos marcados por la cultura organizacional de la universidad en la que laboran. En este contexto, con las atribuciones que les otorga la autonomía institucional, las universidades públicaspueden asumir un rol de liderazgoal definir procedimientos organizacionales que permitan medir el impacto de sus investigaciones aplicadas.

4. RESULTADOS Y DISCUSIÓN

La UAQ es la institución educativa con mayor oferta de carreras universitarias en el estado de Querétaro. En 2017,contaba con 572 Profesores de Tiempo Completo (PTC), 98% de ellos con estudios de posgrado. La productividad científica de sus investigadores, medida a través de publicaciones en revistas indizadas , fue de 0.54 artículos por PTC, lo que la situaba en el cuarto lugar nacional (UAQ, 2018a).

Para la UAQ, la investigación científica es una actividad que refleja el compromiso que mantiene con su entorno. Esto es así, pues el conocimiento que produce se vincula con los problemas del país (UAQ, 2018a).Por ello, uno de los objetivos estratégicos que se ha trazado como organización es lograr la excelencia en investigación con proyección social, de forma que se generen conocimientos para promover el desarrollo económico y el bienestar social a nivel estatal, regional y nacional. (UAQ, 2015).

En la administración actual (2018-2021) se ha reforzado esta visión a través de la Responsabilidad Social Universitaria , modelo de gestión organizacional que permite dar respuesta a los impactos de la institución (UAQ, 2018b).

Los indicadores de evaluación académica referidos en documentos de planeación, informes de resultados y evaluaciones, retoman los propuestos por la política científica federal, vinculando el impacto con la productividad académica (UAQ, 2015a; UAQ, 2015b; UAQ, 2018a).

La investigación “…representa la capacidad de generación de nuevos conocimientos y, por lo tanto, a través de ella se pueden estimar el impacto y la influencia que nuestra institución tiene en la sociedad (UAQ, 2015b: 15).

La investigación “…representa la capacidad de generación de nuevos conocimientos y, por lo tanto, a través de ella se pueden estimar el impacto y la influencia que nuestra institución tiene en la sociedad (UAQ, 2015b: 15).

La investigación “…representa la capacidad de generación de nuevos conocimientos y, por lo tanto, a través de ella se pueden estimar el impacto y la influencia que nuestra institución tiene en la sociedad (UAQ, 2015b: 15).

Dada la importancia de los fondos concursables, sus indicadores de evaluación se encuentran presentes tanto en los procedimientos de contratación y promoción laboral como en el programa de estímulos de la UAQ. Los tabuladores de evaluación de estos procedimientos organizacionales determinan qué actividades y resultados son valorados por la institución, transfiriendo criterios de evaluación de la organización en su conjunto hacia la evaluación del desempeño de su personal. Esto es coincidente con lo señalado para varias universidades del país (Gil, 2014; Gil y Contreras, 2017).

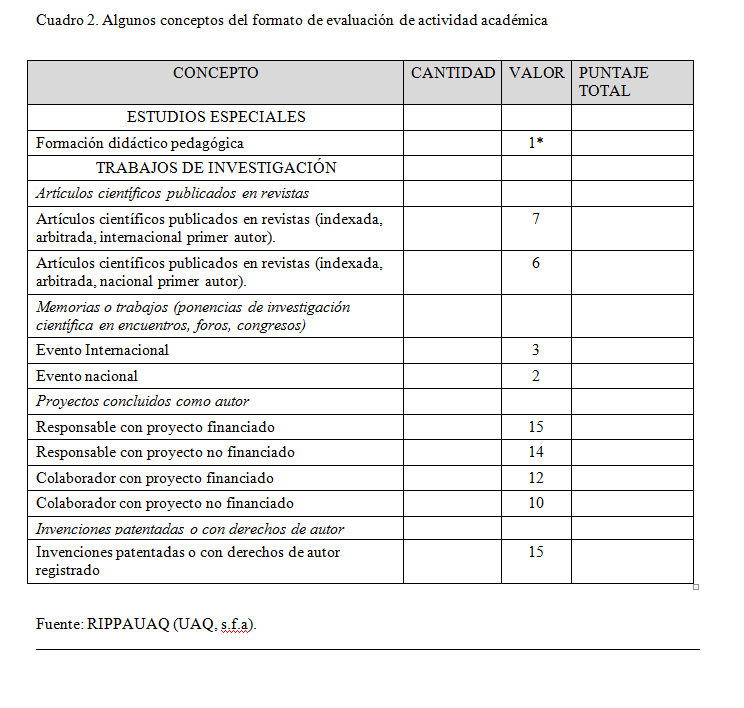

En este sentido, el Reglamento de Ingreso y Promoción del Personal Académico de la Universidad Autónoma de Querétaro, RIPPAUAQ (UAQ, s.f.a), define un sistema cuantitativo de evaluación académica que se utiliza para tomar decisiones y orientar el comportamiento de los PTC hacia un desempeño idóneo como trabajadores de la universidad (Cuadro2). Destacan por su valor los artículos científicos publicados en revistas indizadas o arbitradas, ser responsable o colaborador de proyectos registrados (los cuales normalmente implican el compromiso de entregar como producto un artículo científico), y el registro de propiedad intelectual.

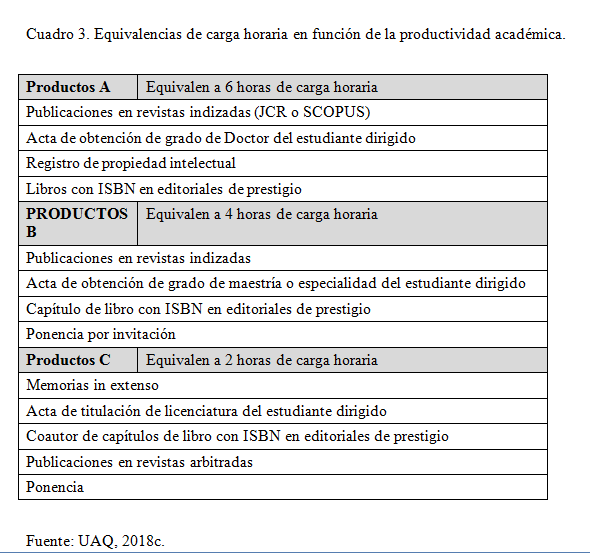

Recientemente, se definió un procedimiento para el registro de proyectos de investigación con financiamiento interno, con la finalidad de vincular la carga horaria a la productividad del investigador. Su propósito es promover una mayor eficiencia en el trabajo del personal académico a través de métricas que valoren su desempeño (Cuadro 3).

Los procedimientos mencionados hasta ahora tienen el propósito de evaluar el desempeño de individuos (académicos) y organizaciones (UAQ). Sin embargo, es importante distinguirlos de los procedimientos que la UAQ utiliza para evaluar proyectos de investigación en sí.

La Dirección de Investigación y Posgrado (DIP) es la instancia responsable del proceso de registro y seguimiento de los proyectos de investigación que se realizan en la UAQ. Los protocolos de investigación, diseñados a partir de un formato predeterminado, son dictaminados por pares para evaluar exante su validez científica.

En relación a las “posibles aplicaciones” del conocimiento, los protocolos deben incluir apartados en donde se justifique la relevancia social de la investigación, indicando los beneficios que se espera obtener. En este sentido, se solicita a todas las investigaciones plantear las consecuencias prácticas de los conocimientos, pensando en su aplicación.

Por otro lado, el protocolo es dictaminado por un comité de ética de la investigación, instancia que valora el cumplimiento de estándares que garanticen la protección de la integridad y dignidad de los seres humanos que participen en la investigación, así como el bienestar animal.

La evaluación expost de los proyectos registrados se concentra en torno de la entrega de los productos académicos comprometidos. Estos pueden ser publicaciones, ponencias en congresos, registros de propiedad intelectual o la formación de recursos humanos (tesis).

En relación a la estimación del impacto de investigaciones aplicadas, la UAQ reconoce las limitaciones de su sistema de evaluación. Una revisión de la estrategia para orientar la investigación hacia la resolución de problemas sociales, contenida en el Plan Institucional de Desarrollo 2015-2018, concluyó que la institución no cuenta con mecanismos para medir el impacto de los proyectos (UAQ, 2018d).

4.2 Discusión

El sistema de evaluación de la UAQ, orientado a la medición de la productividad académica, se alinea con la política científica federal, lo cual es crucial en el contexto de limitación presupuestal que atraviesa la institución. Sin embargo, esto no garantiza la congruencia con el enfoque de la responsabilidad social universitaria, pues no es posible equiparar la producción de conocimiento con su impacto.

La evaluación basada en indicadores cuantitativos podría afectar el comportamiento de los investigadores, al orientarlos hacia las métricas como fin en sí mismo.Por ello, sería conveniente plantear investigaciones que estudien este fenómeno e integren la percepción de los académicos para reconocer las formas específicas en que los instrumentos inciden en su toma de decisiones.

Con esto no se quiere decir que las valoraciones de desempeño no sean necesarias. La ausencia de estándares podría provocar un déficit de rendición de cuentas por lafalta de mecanismos para orientar el desempeño deseado. En este sentido, se considera útil la propuesta de la UAQ de vincular la carga horaria con la efectividad.

Sin embargo, por las distorsiones que puede provocar, es necesario trascender la visión limitada de la rendición de cuentas basada en métricas cuantitativas. Este enfoque, si bien, garantiza la “objetividad”, no implica un juicio informado sobre la relevancia del trabajo.

Desde una perspectiva más amplia, la rendición de cuentas implica ser responsable de lo que uno ha hecho, y estar comprometido con los objetivos que se desea conseguir (Ebrahim, 2003; Guijt, 2010). Este enfoque mide e incentiva que los individuos, orientados hacia los cambios que desean intencionar, planeen cómo conseguirlos y evalúen la efectividad de sus acciones, con la finalidad de ajustarlas para desempeñarse mejor (Mayne, 2010).

Se ha sugerido modificar los criterios utilizados para tomar decisiones de contratación y promoción laboral, de manera que, al valorar el desempeño de un investigador, el tipo de revista o la cantidad de publicaciones sean sólo una variable dentro de una amplia gama de indicadores cualitativos y cuantitativos para medir el impacto de las investigaciones (Cagan, 2013).

Un sistema de evaluación orientado al impacto necesitaría ampliar la comprensión de la calidad, al requerir que, más allá del cumplimiento de los estándares metodológicos de su disciplina, los investigadores inviertan en estrategias para promover la toma de decisiones basada en conocimiento (Bensinget al., 2013).

A su vez, como sugiere Turnhout (2018), es necesario que los investigadores se cuestionen cómo están impactando, dado que la producción de conocimiento utilizable no puede considerarse un ideal en sí mismo. Esto es así, afirma, porque algunos conceptos que tienen aceptación generalizada podrían enmascarar consecuencias perniciosas para ciertos actores, así como una distribución desigual de beneficios. Por ello, la reflexión crítica y el diálogo con los grupos involucrados son esenciales para garantizar la calidad de las investigaciones aplicadas.

En este sentido, la UAQ ha impulsado una política para revalorizar la vinculación como función sustantiva de la organización. Esta estrategia es congruente con su modelo de gestión universitaria, al orientar las acciones de su personal hacia la atención de problemas sociales.

En específico, para proyectar los conocimientos hacia la sociedad (UAQ, 2015a),la UAQ permite el registro y financiamiento de proyectos de vinculación, los cuales tienen el mismo valor que los proyectos de investigación en los tabuladores de evaluación académica. Esto implica su reconocimiento como carga horaria, y su incorporación en convocatorias de obtención de plaza, promoción docente y estímulos.

Este procedimiento facilita que los investigadores promuevan el uso del conocimiento para atender “…problemas prácticos y actuales a escala local, regional o nacional en vinculación con los sectores productivo, gubernamental, educativo y la sociedad en general.” (UAQ, s.f.b).

En la literatura se ha señalado el riesgo de que la vinculación no sea una prioridad de los académicos mexicanos, pues los criterios de evaluación se enfocan en actividades de investigación y docencia (Galaz et al., 2008).La política de vinculación de la UAQ parece un paso en la dirección correcta para atender esta deficiencia.

Sin embargo, la UAQ utiliza los mismos indicadores de productividad académica para medir los resultados de proyectos de vinculación. Si bien es válido que se genere conocimiento sobre los mecanismos que conducen al cambio, en esencia los proyectos de vinculación buscan generar impactos sociales, no cognitivos. Por ello, deberían ser evaluados bajo el marco de evaluación de proyectos de desarrollo, con la finalidad de estimar los efectos generados por las intervenciones.

Es una tarea pendiente explorarel grado en que el mecanismo incentivaque los académicos de la UAQ liguen sus proyectos de investigación con proyectos de vinculación.

5. CONCLUSIONES

Si no podemos medir lo que es valioso, entonces empezaremos a valorar lo que es medible. -Robert Birnbaum-

Los valores representados en el sistema de evaluación académica de la UAQ, centrado en el cálculo de productividad académica, corresponden con los de la política científica federal. Sin embargo, existe una contradicción entre esos valores y la responsabilidad social universitaria, modelo de gestión que se orienta hacia la medición y manejo de impactos organizacionales.

Es interesante reflexionar en el margen de maniobra que tienen las Universidades Públicas Estatales para proponer esquemas que se distingan del arreglo institucional que norma su actuación. En definitiva, su autonomía institucional es un campo de acción para decidir si reproducen estructuras hegemónicas o si adoptan valores propios que conduzcan su comportamiento.

Requiere tiempo involucrarse en mecanismos de deliberación para promover cambios que favorezcan a grupos vulnerables y al ambiente. Este objetivo suele ser un proceso social y político de larga duración que con frecuencia falla debido a su complejidad.

Por ello, si la valoración del desempeño de los investigadores no toma en cuenta las características de esta absorbente e incierta tarea, se corre el riesgo de que los académicos prioricen acciones que «dan puntos», más allá del impacto científico y social que puedan tener (Suárez y Muñoz, 2016).

Al asumir su responsabilidad social, la universidad necesita una visión de largo plazo que facilite el involucramiento de los investigadores en la promoción de cambios transformacionales. En este contexto, las evaluaciones son una herramienta de aprendizaje organizacional para que equipos interdisciplinarios de académicos mejoren su capacidad de incidir en problemáticas locales.

Por ejemplo, en torno del manejo sostenible de Áreas Naturales Protegidas, no es suficiente realizar estudios de gobernanza institucional, análisis sobre el cambio de uso de suelo, propuestas de ordenamiento territorial, monitoreo de plagas forestales o evaluaciones de programas. Es necesario complementar la generación de conocimiento con actividades de intercambio que permitan co-crear soluciones suficientemente buenas.

Por ello, es fundamental el diseño de procedimientos organizacionales que orienten el comportamiento de los académicos hacia este objetivo. A continuación, se presentan una serie de propuestaspara estimular conversaciones sobre cómo mejorar la manera en que se evalúan las investigaciones aplicadasde la UAQ.

Las ideas se retoman de las siguientes metodologías de evaluación:

- Evaluating Research in Context (Van der Meulen et al., 2010).

- Participatory Impact Pathways Analysis (Álvarez et al., 2010).

- Social Impact Assesment Methods through Productive Interactions (Spaapen et al., 2011).

1. Incorporar teorías del cambio en la fase de diseño de las investigaciones aplicadas. Se propone que, como parte de la calidad esperada en investigaciones aplicadas, sea obligatorio incorporar una teoría del cambiodonde se describan las contribuciones sociales que se busca generar con la investigación, así como la estrategia que se adoptará para conseguirlo.

La representación gráfica del proceso de cambio, implica identificar:

a) los conocimientos que se generarán,

b) los mecanismos de interacción con otros actores para promover cambios a partir del conocimiento,

c) los supuestos bajo los cuales la teoría del cambio funciona.

Concebir las investigaciones de esta manera permite incorporar la evaluación como una herramienta de mejora continua, puesto que los resultados obtenidos son útiles para refinar la teoría del cambio original.

El procedimiento puede incluirse en el sistema de gestión de la calidad para el registro de proyectos de investigación que es utilizado por la DIP. Específicamente, para evaluarexante la calidad y relevancia de la investigación.

Aunado a lo anterior, este procedimiento es útil para la planeación estratégica de cuerpos académicos y centros de investigación.

2. Permitir que los investigadores desarrollen los indicadores con los que se valorará el impacto de sus contribuciones.Existen diferencias significativas en el contexto de intervención de diferentes disciplinas científicas. Por ello, es importante adaptar los indicadores que se utilizarán para valorar la relevancia social de la investigación aplicada.

En el formato para presentar el protocolo de investigación, los académicos de la UAQasumen por sí mismos las contribuciones sociales que esperan generar. Como parte del registro de proyectos de investigación, se les puede solicitar el desarrollo de indicadores de resultado y de impacto que se relacionen conlos beneficios esperados.

Actualmente, los académicos comprometen productos académicos que son equivalentes al resultado inmediato de la investigación.La propuesta es complementar esa métrica con indicadores cuantitativos, cualitativos, y/o monetarios que permitan estimar los efectos de la investigación. Estos indicadores podrían reflejar: a) el grado en que el conocimiento se dispersó entre los grupos interesados , b) el grado en que los grupos interesados muestran interés y valoran los resultados de la investigación , o c) evidencia del uso e impacto del conocimiento.

Además, como parte del proceso, se pueden solicitar autoevaluaciones expost donde los propios investigadores utilicen sus indicadores para reflexionar sobre el cambio que han conseguido. El objetivo es promover un proceso de aprendizaje sobre los mecanismos necesarios para conseguir el impacto.

3. Financiar y evaluar actividades para mantenerinteracciones productivas con grupos interesados. Las interacciones ocurren cuando existe contacto entre los investigadores y otros actores. Por ejemplo, a través de mecanismos como una publicación, un reporte, un prototipo, un manual, una página web, o la recepción de financiamiento. Éstas son productivas cuando inducen un cambio de comportamiento en los grupos involucrados (Spaapen et al., 2011).

En lugar de medir el impacto de las investigaciones, este indicador proxyse concentra en los procesos que ocasionarían un impacto. Si bien, se puede calcular el impacto económico de investigaciones relacionadas con la innovación y la transferencia de tecnología, con frecuencia es muy difícil estimar los impactos de las investigaciones por problemas de atribución y latencia. Por ello, este enfoque propone la medición de actividades que son condiciones necesarias para que el impacto pueda ocurrir (Spaapen y van Drooge, 2011).

En específico, se propone incorporar este indicador dentro del sistema de gestión de la calidad utilizado por la DIP. El propósito es garantizar la incorporación de interacciones productivas en las investigaciones aplicadas. Además, en la fase de verificación, la DIP puedeutilizar este indicador como evidencia objetiva de compromiso social.

6. REFERENCIAS

Alvarez, S., Douthwaite, B., Graham T., Mackay, R., Cordoba, D. y Tehelen, K. (2010). Participatory Impact Pathways Analysis: a practical method for project planning and evaluation. Development in Practice, 20, 946-958.

Arocena, R., Göransson, B., Sutz, J. (2018). Towards making research evaluation more compatible with developmental goals. Science and Public Policy, scy051, https://doi.org/10.1093/scipol/scy051.

Bensing, J., Andeweg, R. Franses, Ph., Meyer, B., Prins, C., y Schuyt K. (2013). Towards a Framework for the Quality Assessment of Social Science Research. Amsterdam, Holanda: Royal Netherlands Academy of Arts and Sciences.

Bentley, J. (2018). Decreasing operational distortion and surrogation through narrative reporting. The Accounting Review, en proceso de publicación.

Bovens M., Schillemans T. y Hart P. (2008). Does public accountability work? An assessment tool. Public Administration, 86 (1), 225-242.

Cagan, R. (2013). The San Francisco Declaration on Research Assessment. Dis Models Mech 6, 869-870, doi:10.1242/dmm.012955

| |||||